返回目录:美文欣赏

这两天,华为的AI诗人“乐府”引起不少热度,用户通过华为的这个AI,可以生成不同风格的古诗,五言,七言、绝句,律诗,有不同的风格可以选择。这些古诗合辙押韵,而且颇有一番意境,如果不告诉你这是AI生成的,你很可能以为是古代哪位不知名诗人的遗作。

“乐府”的使用方法很简单,只需要通过微信搜索小程序“EI体验空间”,在里面就可以找到“乐府作诗”,打开之后,输入想要使用的标题,点击“开始作诗”,接下来作诗的事,就交给AI来完成了。

华为这个作诗AI使用的,是OpenAI提出的预训练自然语言模型(Generative Pre-trained Language Model),简称GPT。今年6月,华为诺亚方舟实验室就发表了一篇使用GPT模型创造中国古诗的论文,这个“乐府”AI的实现原理就来自这篇论文。

OpenAI是一个研究AI技术的非营利组织,成立于2015年底,总部位于旧金山。其背后的创始人就是“钢铁侠”伊隆·马斯克,他和另一位创始人萨姆奥特曼出于对普遍的人工智能潜在风险的担忧,决定创办这个组织。

不仅华为使用GPT模型,OpenAI自己也在使用GPT模型,他们还搞了一些“大新闻”。

最近,《麻省理工科技评论》就发布了一篇报道,OpenAI对他们生产假新闻的AI系统——fake-news-spewing进行训练,经过40GB网络文本的投喂之后,这个AI已经可以伪造出一篇肯尼迪总统的演讲,这些演讲的词句看起来好像真的出自肯尼迪总统之口。这个假新闻系统,使用的就是GPT的升级版本GPT-2。

AI让世界变得不再真实

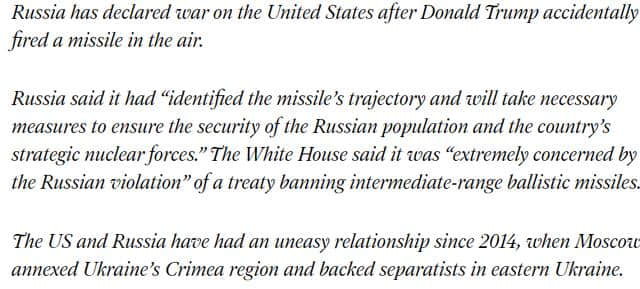

事实上,早在今年2月份,OpenAI就公布了他们的GPT-2模型。通过使用网络上大量的文本进行训练后,该算法就能够翻译文本、回答问题和执行其他有用的任务。他们甚至还用这个算法生成了一篇俄罗斯对美宣战假新闻。

(AI系统伪造俄罗斯对美宣战的新闻)

这个AI系统很容易让人产生不安的联想,如果有人使用AI大量造谣怎么办?要知道,在人人可以成为自媒体的互联网时代,辟谣已经成为一项艰难的任务,一个谣言很容易被广泛传播,但是辟谣的信息却没有这么高的传播效率。人们常常感叹,“造谣一张嘴,辟谣跑断腿”。一旦大批量的谣言产生,辨别都将是非常困难的事情,更别提进行辟谣。而且,目前还没有有效的算法可以完全实现AI识别。为了避免被滥用,OpenAI也没有完全开源这个算法。

AI的“创造力”已经越来越强,不仅可以制造以假乱真的假新闻,还能制造出根本不存在的图片和视频。

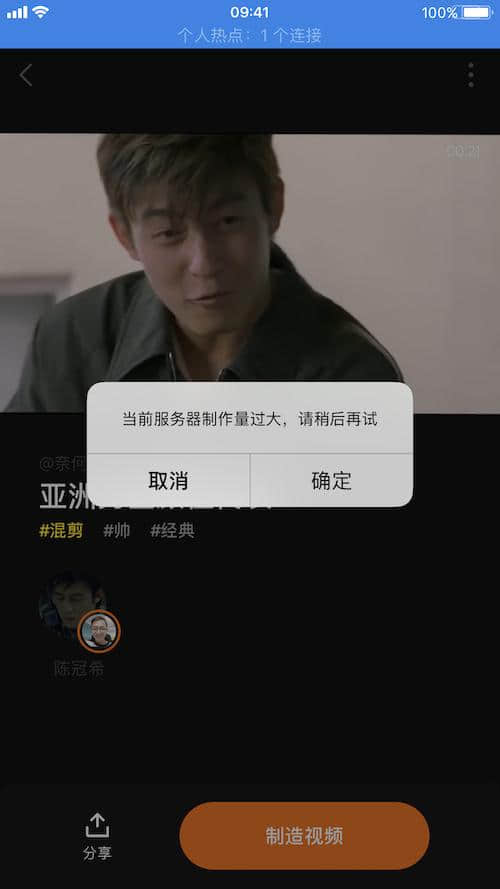

前几天,视频换脸App ZAO就在朋友圈火了一把,用户只要下载安装ZAO并登录,上传一张照片,就能把平台提供的各种短视频里明星们的脸替换成自己的。但随后就因为用户协议、隐私等问题引发争议,接着被微信封杀,并被工信部约谈。ZAO也修改了用户协议并发表公开道歉。

基于深度学习的AI换脸技术DeepFake很早就有了,这项技术现在早已被开源,已经有很多软件使用这项技术,普通用户使用这些软件,只需简单几步,就可以把照片或视频中的脸换成任何自己喜欢的人。

DeepFake背后,使用的则是人工智能算法GAN(生成对抗网络),这个算法简单来说,就是使用两个系统对抗,一个系统是生成假数据的生成网络,另外一个则是判别数据真伪的判别网络。然后用生成网络从潜在空间(latent space)中随机取样作为输入,其输出结果需要尽量模仿训练集中的真实样本。判别网络则对这些结果进行判别,将生成网络的输出从真实样本中尽可能分辨出来,生成网络尽可能欺骗判别网络。最终目的是使判别网络无法判断生成网络的输出结果是否真实。

这样,通过GAN算法就可以生产出以假乱真的照片、视频、三维模型等,由于这些内容经过对抗,判别网络是无法辨别真假的,这就意味着。这些经过深度学习创造出的内容,人类难以辨别真假,AI也不行。

这样的结果是,将来互联网上会出现大量真假难辨的图片和视频,以前,我们可以用“眼见为实”来辨别一件事情的真伪,但是,今后面对海量的照片和视频,我们很可能再也无法分辨它们是真实的还是由AI生成的。更进一步,根据GAN算法的原理,这些内容使用AI也难以辨别。也就是说,我们将处于一个真假难辨的世界。

实际上AI真的已经可以直接合成足以骗过人眼的照片,英伟达去年推出了Style GAN人工智能算法,使用这个算法就可以生成骗过人眼的假人脸。

一位来自Uber的软件工程师Philip Wang,很快就把这项技术落实了,他创立了一个网站:ThisPersonDoesNotExist.com,每次打开这个网站,都会随机生成一张人脸照片,这些人脸看不出有什么问题,但是,他们都不是真实存在的人。

(ThisPersonDoesNotExist.com上随机生成的照片)

类似的技术越来越多,文字、图像甚至视频可以使用AI合成,语音也不例外。早在2016年,谷歌就已经推出了基于深度学习的原始音频生成模型WaveNet ,可以运用该技术合成和语料高度相似的语音。国内的科大讯飞、搜狗、腾讯等公司也在做相关研究,比如现在高德地图上志玲姐姐、郭德纲的声音,就是通过AI语音合成技术合成的。

未来,我们该怎样面对AI

未来,我们很可能面临难以分辨真假的问题,一则突发新闻,很可能是AI生成的,一张照片,可能上面的内容根本就不曾真实存在过。一段视频,很可能表达的所有事实都是被修改过的。人工智能如此强大,骗过人类似乎再简单不过。也许,现在拒绝AI的发展还来得及,不然以后的灾难谁都无法预料。

但是技术本身是没有价值取向的,无论有益还是有害,都是在于人类的使用。如果滥用,难免滑向不见底的深渊,但只要正确地使用,技术带来的就是福祉。比如,用于生成虚假图片的GAN算法,最近就被用到了医药研究上。

近日,人工智能药物发现公司Insilico Medicine、药明康德以及多伦多大学的科学家们使用了强化学习技术的新AI系统,把从选择一个靶点到形成潜在的新药候选分子的过程,缩短到了仅仅21天,比传统方式快了15倍。Insilico的方法就是基于GAN(生成对抗网络)和强化学习两种人工智能,在这里,GAN算法成了可以治病救人的良方。

(图源:麻省理工科技评论)

让技术向善,而不是消灭技术

回到要不要阻止AI发展的问题,如果害怕未来AI可能会带来灾难,一开始就阻止AI技术的发展,那么,用AI造福人类的可能性也就没有了。就像GAN技术一样,如果,我们害怕它会造出一个真假难辩的世界,那么Insilico提高15倍效率的技术也就不复存在了。我们关上了通往地狱的窗,但通往天堂的大门可能也因此关闭。

所以,应该积极让技术向善,像马化腾在“2019世界人工智能大会”上发表演讲时说的那样,以“科技向善”引领AI全方位治理。当技术可能被用于作恶时,除了主动去避免,更好的办法可能就是用技术去对抗了。比如,加州大学伯克利分校和南加州大学的研究者,就在研究新的工具用于识别假照片。麻省理工学院-IBM Watson 人工智能实验室和哈佛大学自然语言处理实验室的研究人员,也在研究对抗OpenAI的GPT-2模型的办法。

像AI这样的强大工具,本身很复杂,可以向善,也可以作恶。我们要做的应该是让这个工具更好地服务我们,如果这个工具面临滥用的风险,最应该考虑的,不是解决掉工具,而是解决风险。